李明:ChatGPT在医疗领域的应用及其挑战概述

人工智能ChatGPT悄然来袭,其强大的语言生成能力让许多行业为之兴奋。那它对医疗健康领域又将带来什么影响呢?我们一起来看看!

ChatGPT自2022年11月发布以来,在医疗领域引起了众多人士的广泛关注,很多学者也积极探索ChatGPT在医疗领域应用的实践。媒体很多报道集中在临床应用、患者沟通和医学教育等一些场景的应用上,本文从当前学术研究的视角看ChatGPT在医疗领域的实际应用。结合ChatGPT在科研写作、医疗教育、临床研究和实践中的应用前景及相关问题,探讨其优势与局限性。

ChatGPT在医疗领域的应用优势

ChatGPT作为一种先进的人工智能聊天机器人,在医疗和学术领域有着广泛的应用前景。

(1)学术/科学写作应用

超过一半的研究文献特别强调了ChatGPT在学术和科学写作方面的潜在优势。医学写作不仅仅局限于科学论文的创作,它涵盖了从检查报告、监管文件、患者教育材料到临床实验方案等各种基于文本的交流。此外还可以将医学文章翻译成多种语言。ChatGPT的训练方法是基于人类反馈的强化学习,其中包括筛选和标记文本。这种技术允许机器根据人类评估者的输入调整其行为。因此,ChatGPT在理解用户意图、人类的生成式文本以及保持文本连贯性方面表现出色。

经过医学写作训练的ChatGPT可以根据作者的指示为文档生成初稿,从而为医学作者提供初步的写作支持。之后,作者可以审查和编辑这些生成的文本,确保其准确性和清晰度。此外,ChatGPT还可以自动化审查和编辑流程,为多个审稿人提供文档的反馈和建议,从而提高写作效率。

ChatGPT的这些功能不仅提高了研究的质量,还为研究者节省了大量时间。对于那些非英语为母语的作者,ChatGPT提供了一个便捷的英文写作工具,帮助他们克服语言障碍,更加流畅地进行学术交流。但值得注意的是,尽管ChatGPT在写作方面提供了很大的帮助,最终的文档仍然需要经过人类的审查和判断,以确保其质量和准确性。

(2)在科学研究应用

ChatGPT已经在科学研究领域被认为是一种高效且有潜力的工具,特别是在进行全面的文献综述和生成计算机代码时。这种工具为研究人员节省了大量时间,特别是在那些需要深入思考的研究过程中,例如流行病学研究和实验设计。

在流行病学研究中,STROBE指南被广泛采用。这些指南为报告研究的各个方面提供了明确的建议,如研究设计、参与者的选择、暴露和结果的测量,以及结果的分析和解释。意大利的研究者利用STROBE检查表作为基础,为ChatGPT制定了问题。他们让ChatGPT将STROBE清单的每一项转化为具体的问题或提示。接着,ChatGPT回答这些问题,为流行病学研究提供了有力的支持。领域专家随后评估了ChatGPT对每个提示的回答,特别是其连贯性和相关性。结果显示,ChatGPT在连贯性上的平均得分为3.6(满分5.0),在相关性上的平均得分为3.3(满分5.0),这表明ChatGPT为流行病学研究提供了有价值的支持。

此外,ChatGPT在处理大数据,如电子健康记录或基因组数据时显示出其高效性。这意味着科学家们可以将更多的时间用于思考和设计实验,而不是被复杂的数据分析所困扰。在药物设计和发现方面,ChatGPT也展现出了巨大的潜力,有望加速药物研发的进程。

(3)临床实践上的研究

从临床实践的角度看,多数研究者对ChatGPT的临床应用持相对谨慎的态度。然而,ChatGPT在简化临床工作流程方面展现出了巨大的潜力,这不仅可能帮助医疗机构节省成本,还能提高工作效率。例如,ChatGPT能够自动生成高效的出院小结,从而减轻医生的文书工作负担。

在放射学领域实践上,ChatGPT的答案与美国放射学会(ACR)关于乳房疼痛和乳腺癌筛查的适当性标准进行了比对。在开放式(OE)提示格式中,ChatGPT被要求推荐最合适的单一成像程序;而在选择所有适用(SATA)格式中,ChatGPT则提供了一个待评估的成像模式列表。根据评分标准,ChatGPT的建议是否与ACR指南相符进行了评估。对于乳腺癌筛查,ChatGPT的OE平均得分为1.83(满分2分),SATA的平均正确率为88.9%;而对于乳房疼痛,OE的平均得分为1.125,SATA的平均正确率为58.3%。这些数据验证了ChatGPT在放射学决策中的应用潜力,它有助于优化临床工作流程并更加负责任地利用放射学服务。

此外,ChatGPT在提高个性化医疗服务方面也展现出了其优势。它能够为患者提供易于理解的健康信息,提高他们的健康知识素养。ChatGPT能够根据具体的问题提供定制化的答案,并依据最新的研究和指南为医疗决策提供基于AI的建议。这意味着,医务人员无需逐篇查阅相关指南和研究,就可以快速获取AI总结和提炼的关键信息。

总的来说,ChatGPT为医疗行业带来了新的视角和工具。它不仅可以帮助医生更准确地预测疾病的风险和结果,为患者提供更加个性化的治疗方案,还可以优化诊断和记录流程。对于那些日常工作繁重的护士,ChatGPT则可以成为他们的得力助手,帮助他们简化工作流程,提高工作效率。

(4)在医学教育方面的应用

在医学教育领域,ChatGPT同样展现了巨大的潜力,逐渐成为医学教育的重要辅助工具。ChatGPT 已经通过一些国家执业医师的考试比如美国的 USMSL,在帮助医学生学习和复习时确实显示出了其价值。ChatGPT能够生成准确且广泛的临床教育内容,为学生提供个性化的学习体验,并在小组学习中发挥助教的作用。其个性化的交互方式极大地增强了自主学习的能力,同时还能为医学生提供职业沟通技巧的指导和培训,使医学教育更加全面。

例如,在眼科检查的研究中,Antaki等人发现ChatGPT的表现与初级住院医师的水平相当。这意味着,通过特定的预训练,我们可以进一步为眼科医生提供更加专业化的培训,从而提高他们在眼科子专业中的技能和知识。

总的来说,ChatGPT为医学教育带来了新的机会和挑战,未来在这一领域还有很大的发展空间。

ChatGPT医疗应用潜在的局限性和风险

我们必须认识到,ChatGPT是双刃剑,不可忽视其局限性与潜在的风险。法律角度上,人工智能生成的内容应用于商业目的时须注意不侵犯版权,人类作者必须确定人工智能生成的文本符合相关法规和法律。

需要指出的是,当前版本的ChatGPT在医疗应用各种测试中仅取得了“中等”或“及格”的性能,并且对于实际临床部署不可靠,因为它本身最初不是设计用于临床应用的,所以ChatGPT在医疗领域应用中仍有一定的局限性。但是,在医学数据集上训练的专业NLP模型仍然代表了临床应用的主导方向。

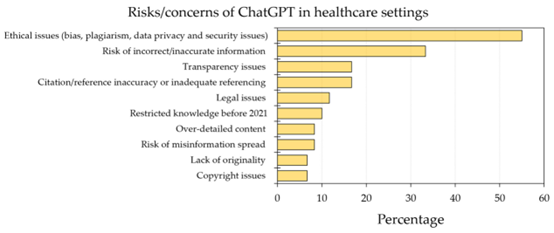

根据目前文献研究,大部分提到了与道德和伦理有关的问题,其中包括偏见风险(30.0%)、抄袭风险(30.0%)和数据隐私及安全问题(23.3%)。这些问题不仅限于道德层面,还涉及到实际应用中可能出现的多种风险,如不准确信息的传播(33.3%)、引用不当(16.7%)和透明度不足(16.7%)。此外,还有一些法律问题(11.7%)和关于使用过时信息(10.0%)的担忧。更有甚者,一些研究还提到了误传风险(8.3%)、内容过于详细(8.3%)、版权问题(6.7%)和缺乏原创性(6.7%)。

Sallam M. Healthcare (Basel). 2023 Mar 19;11(6):887.

笔者实际测试过程中,发现ChatGPT可以提供看上去极为真实的参考文献,但实际不存在,主要根源是 ChatGPT根据上下文的内容推测生成。现在提交SCI论文时,大部分期刊要求注明是否借鉴了AIGC工具协助创作。

ChatGPT应用规范建议

综合当前文献的研究结论,笔者提出了ChatGPT的应用规范的原则建议。

研究透明性:研究人员在使用ChatGPT时,应全面披露其在研究中的应用,并对生成的内容进行严格校验,确保其原创性和可信度。

医疗应用的补充性:医务人员在使用ChatGPT时,应当明确内容的局限性,将ChatGPT提供的内容作为其专业判断的补充,而非替代。

医学教育策略:医学教育工作者在使用ChatGPT时,应调整教学策略,防止其被用于不正当目的,如作弊,并应更加注重培养学生的批判性思维能力。

出版和审查机制:出版界应建立有效的审查机制,以识别和管理由ChatGPT生成的内容,确保学术的诚信和质量。

道德和监管规范:应制定相应的道德和监管规范,加强对ChatGPT及类似工具的管理,确保其安全、负责任的应用。

持续评估和研究:鉴于ChatGPT及类似工具的快速发展,我们需要持续进行影响评估和风险研究,以适应不断变化的技术环境。

作者资格的明确:根据现有的科学论文作者资格标准,ChatGPT并不符合作为作者的资格。因此,任何由其生成的内容都应当被明确标注,并由真实的作者进行监督和审查。

ChatGPT与医疗领域的交汇,为我们打开了一个充满无限可能的新世界, 具有推动医疗进步的重要意义,但同时也伴随着一系列的挑战。为了确保其在医疗领域的负责任和有效应用,我们必须正视这些挑战,建立相应的道德和监管规范,并持续进行影响评估和风险研究。同时需要保持开放和审慎的态度,继续积极而负责任地推动医疗技术创新,ChatGPT才能真正为医疗领域带来革命性的变革,并为更多的患者带来福音。

参考文献:

1.Kitamura, F.C. ChatGPT Is Shaping the Future of Medical Writing but Still Requires Human Judgment. Radiology 2023, 230171.

2.Shen Y, Heacock L, Elias J, Hentel KD, Reig B, Shih G, Moy L. ChatGPT and Other Large Language Models Are Double-edged Swords. Radiology. 2023 Apr;307(2):e230163. doi: 10.1148/radiol.230163. Epub 2023 Jan 26. PMID: 36700838.

3.Shen Y, Heacock L, Elias J, Hentel KD, Reig B, Shih G, Moy L. ChatGPT and Other Large Language Models Are Double-edged Swords. Radiology. 2023 Apr;307(2):e230163. doi: 10.1148/radiol.230163. Epub 2023 Jan 26. PMID: 36700838.

4.Rao A, Kim J, Kamineni M, Pang M, Lie W, Succi MD. Evaluating ChatGPT as an Adjunct for Radiologic Decision-Making. medRxiv [Preprint]. 2023 Feb 7:2023.02.02.23285399.doi: 10.1101/2023.02.02.23285399. Update in: J Am Coll Radiol. 2023 Jun 21;: PMID: 36798292; PMCID: PMC9934725.

5.Ahn C. Exploring ChatGPT for information of cardiopulmonary resuscitation. Resuscitation. 2023 Apr;185:109729. doi: 10.1016/j.resuscitation.2023.109729. Epub 2023 Feb 10. PMID: 36773836.

6.Antaki, F.; Touma, S.; Milad, D.; El-Khoury, J.; Duval, R. Evaluating the Performance of ChatGPT in Ophthalmology: An Analysis.

7.Khan, A.; Jawaid, M.; Khan, A.; Sajjad, M. ChatGPT-Reshaping medical education and clinical management. Pak. J. Med. Sci.2023, 39, 605–607.

8.Benoit, J. ChatGPT for Clinical Vignette Generation, Revision, and Evaluation. medRxiv 2023, Preprint.

上一篇: 视频科普:如何保护医疗数据安全

下一篇: 朱洪涛:医院网络安全常见问题及应用对策

首 页

首 页