CCKS2023-PromptCBLUE中文医疗大模型评测比赛持续开放报名中!

简介

以ChatGPT、GPT-4等为代表的大语言模型(Large Language Model, LLM)掀起了新一轮自然语言处理领域的研究浪潮,展现出了类通用人工智能(AGI)的能力,受到业界广泛关注。在LLM大行其道的背景下,几乎所有的NLP任务都转化为了基于提示的语言生成任务。然而,在中文医学NLP社区中,尚未有一个统一任务形式的评测基准。

为推动LLM在医疗领域的发展和落地,华东师范大学计算机学院王晓玲教授团队联合阿里巴巴天池平台、复旦大学、复旦大学附属华山医院、东北大学、哈尔滨工业大学(深圳)、鹏城实验室与同济大学推出PromptCBLUE评测基准(https://github.com/michael-wzhu/PromptCBLUE),对CBLUE基准(https://tianchi.aliyun.com/dataset/95414)进行二次开发,将16种不同的医疗场景NLP任务全部转化为基于提示的语言生成任务,形成首个中文医疗场景的LLM评测基准。PromptCBLUE将作为CCKS-2023的评测任务之一,已在阿里巴巴天池大赛平台上线进行开放评测,欢迎各位师生报名参赛(刷榜)。

注意:本评测虽然立足于医疗垂直领域,但是其所考察的仍然是大模型面向落地的通用能力与关键技术。欢迎对大模型感兴趣的所有研究人员参与本次评测。

参赛对象

大赛面向全社会开放,个人、高等院校、科研单位、企业、创客团队等人员均可报名参赛。华东师范大学学生可以参赛和参与评奖;阿里集团员工可参赛但不参与奖金分配。

任务介绍

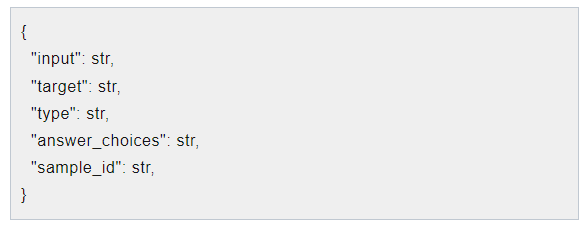

我们采用94个指令微调模板,对CBLUE基准中的各个任务进行改造。经过改造后,医疗文本NLP数据集都将转化为如下格式:input字段是模型的输入,target字段是模型的输出,type是原任务类型(不作为模型输入),answer_choices字段是选项,只有分类、术语标准化、推理类任务上该字段才会有意义。

为了将CBLUE中的各种不同任务适配为符合LLM的输入输出格式,我们对CBLUE各个数据集进行了相应的改造。详见CBLUE任务改造。在本文中我们仅举两个例子:

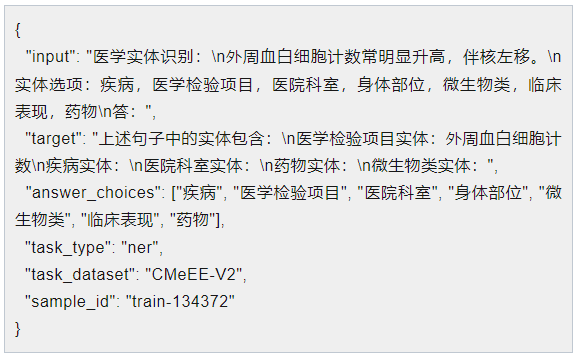

1.CMeEE任务

本任务原本是标准的医学文本NER任务,选手需要给出医学实体mention在待抽取文本中的具体span位置。在PromptCBLUE中,本任务被改造为:根据指定的实体类型,生成实体mention。在评分时,我们只考虑实体mention及其类型标签,不再考虑span位置信息。而且,特别注意的是,为了考察模型的指令理解与服从能力(instruction following),模型只能生成指令中指定的实体类型,而不能生成其他类型的实体。样例如下:

上述样例中的target即为模型输出,而评测参与者需要根据自己的LLM输出进行解析,得到抽取结果。LLM输出的格式可以自己定义,也可以根据我们的样例来进行。

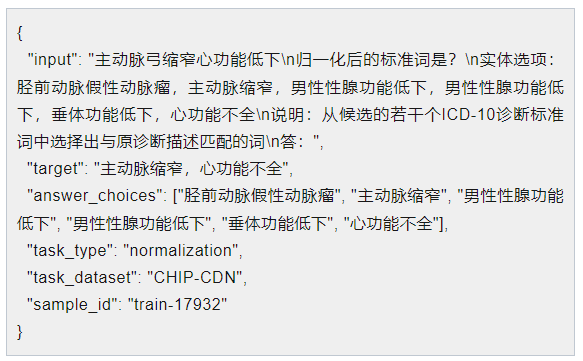

2.CHIP-CDN任务

CHIP-CDN任务在CBLUE中的原型是:给定一诊断原词,要求给出其对应的诊断标准词,而诊断标准词是从ICD-10这一个4w+的标准词库中选择。由于我们不可能一次性将四万个词输入到LLM中(即使是GPT-4服务,最多只能输入32000个token),所以我们将CDN任务改造为:给定原词,从候选的若干个ICD-10诊断标准词中选择出匹配的词(可能有多个, 可能一个都没有)。而在实际业务中,我们可以结合对本地知识库的检索+LLM判断的方式,完整的预测诊断原词对应的诊断标准词。

赛程安排

报名方式及更多信息请点击此处

首 页

首 页